hallo u. guten Abend bitmuncher,

vielen Dank für deine Rückmeldung über die ich mich sehr freue!

Natürlich hat x86 – noch nicht kpl. ausgedient - aber ich denke dass die x86 Generation sehr unter Druck geraten ist. - wo noch Domänen sind - da kann sie die ggf. noch ne weile verteidigen: vielleicht etwa bei Spezialanwendungen, Gaming, Legacy-Software oder hochgetakteten Workstations u. ähnlichem mehr. Ansonsten teile ich deine Ansicht weitgehend.

Die Zeit der x86-Architekturen geht langsam zu Ende. Wenn Windows da nicht bald den Anschluss gewinnt, werden sie in einer Mobile-First-Welt nicht bestehen können.

das sehe ich auch so. ich teile deine Ansicht hier.

Dabei geht es nicht nur um die Batterielaufzeit, auch wenn diese im Consumer-Markt sicherlich ein großes Kriterium ist. Dazu muss ich mir nur anschauen, was der Windows-Laptop bringt, den mein AG mir zur Verfügung stellt vs. mein MacBook Pro. Die Windows-Kiste hänge ich an einem Tag im Office min. 3 Mal an den Strom. Mit nem Apple M2 habe ich zum Feierabend noch 20-30% Strom im Akku ohne zwischendurch aufladen zu müssen.

Ja - das mit der Batterielaufzeit - bzw. mit der Stromaufnahme - das ist nicht das größte Kriterium hier.

Hab auch schon gehoert dass Apple nicht so "hungrig" - also energiehungrig sein soll.

Ein viel größeres Problem von x86-Architekturen ist jedoch auch die Größe und dass es keine zum ARM vergleichbare SoC-Architektur dafür gibt. SoC spielt aber in der KI-Welt eine gewisse Rolle, da man damit auch LLM betreiben kann, ohne eine fette GPU zur Verfügung zu haben. Stattdessen kann man relativ einfach zusätzliche Neural Engines einbinden, wodurch LLM auch lokal laufen können und das Limit der verarbeiteten Tokens dann eher beim RAM liegt und nicht bei der Rechenleistung der GPU und dem VRAM. Damit können kleinere LLM problemlos lokal laufen.

Cooler Gedanke - und das ist wirklich sehr interessant! Also ja - denke dass gerade im Hinblick auf LLMs, Edge Computing und Privacy wird es immer wichtiger, gewisse Rechenlasten lokal zu erledigen. Dass ARM-Systeme mit integrierten Neural Engines. die du ansprichst, hier punkten, ist ein echtes Alleinstellungsmerkmal. Wenn Geräte künftig "AI-ready" sein sollen, führt kaum ein Weg an ARM vorbei – zumindest im mobilen und hybriden Bereich.

Und damit sind wir dann im Server-Bereich, wo dringend eine Übertragung der Kosten an den User notwendig ist, um die Betriebskosten der großen LLM zu senken. Sonst wird's dort nämlich schwierig mit den aktuellen Preisen lukrativ zu werden. Neben der Übertragung der Kosten auf den User durch lokal laufende LLM, werden auch dort ARM-Architekturen für bestimmte Aufgaben der LLM interessanter, weil sie weniger Strom verbrauchen als die GPU-Cluster. Das sieht man u.a. an der wachsenden Nachfrage vom ARM-basierten Servern im B2B-Umfeld.

Natürlich hat x86 – wie oben schon gesagt, ggf. gerade bei Spezialanwendungen, Gaming, Legacy-Software oder hochgetakteten Workstations – noch seine gewisse Daseinsberechtigung. Aber der Paradigmenwechsel ist m.E. doch schon spürbar: Statt mehr Takt geht es zunehmend um spezialisierte Recheneinheiten, Energieeffizienz und modulare Systemintegration.

Hinzu kommt, dass SoC, die zumeist zusammen mit ARM zum Einsatz kommen, viel flexibler an bestimmte Anwendungsbereiche angepasst werden können. Und es ist erstaunlich, dass man das bei Microsoft offenbar noch nicht begriffen hat. Aber dort hat man ja auch das Smartphone-Geschäft viel zu früh aufgegeben. Denn die ersten Ansätze Smartphones mit einer Dockingstation zu PCs umzuwandeln mögen zwar gefloppt sein, aber mittelfristig wird es darauf hinauslaufen, dass wir keine lokalen Rechner mehr haben sondern alles auf mobilen Geräten laufen wird. Und dort werden die sperrigen x86-Architekturen, die mehr Strom in Wärme als in Rechenleistung umwandeln, einfach keine Rolle mehr spielen. Deswegen passt Apple iOS, iPadOS und MacOS mehr und mehr aneinander an und baut Apple Intelligence auf eine Weise, die bisher im KI-Umfeld noch fehlt, nämlich eine großteils lokale KI, an die man problemlos andere LLM anbinden kann. Und zugrunde liegt eine CPU-Architektur, die den mobilen Bereich genauso abdeckt, wie Server und stationäre Rechner.

Ja - teile deine Sicht hier ....

Und dort werden die sperrigen x86-Architekturen, die mehr Strom in Wärme als in Rechenleistung umwandeln, einfach keine Rolle mehr spielen.

Insofern wird die Frage in Zukunft nicht lauten, ob man eine ARM-Architektur in Betracht ziehen wird, sondern eher, welche Alternativen man sonst noch haben wird. x86 wird vermutlich im Consumer-Markt in ein paar Jahren keine große Rolle mehr spielen. Ob im Server-Markt, wird sich noch zeigen, was Intel in Sachen Leistung noch rausholen kann.

Ja - aufs Ganze gesehen eine sehr spannende Entwicklung.

Mal sehen wie es so weitergeht in diesem Jahr - und was auch die Leute von Qualcomm und co so auf den Markt noch bringen werden..

Experience home computing at its finest with Snapdragon X Elite laptops. Enjoy unmatched speed, long battery life, and cutting-edge AI. Shop now!

www.qualcomm.com

Danke jedenfalls für diese sehr interessanten Ideen u. Gedanken zum Thema,

Dir, lieber Bitmuncher u. allen hier noch einen schönen Montagabend,

VG

update:

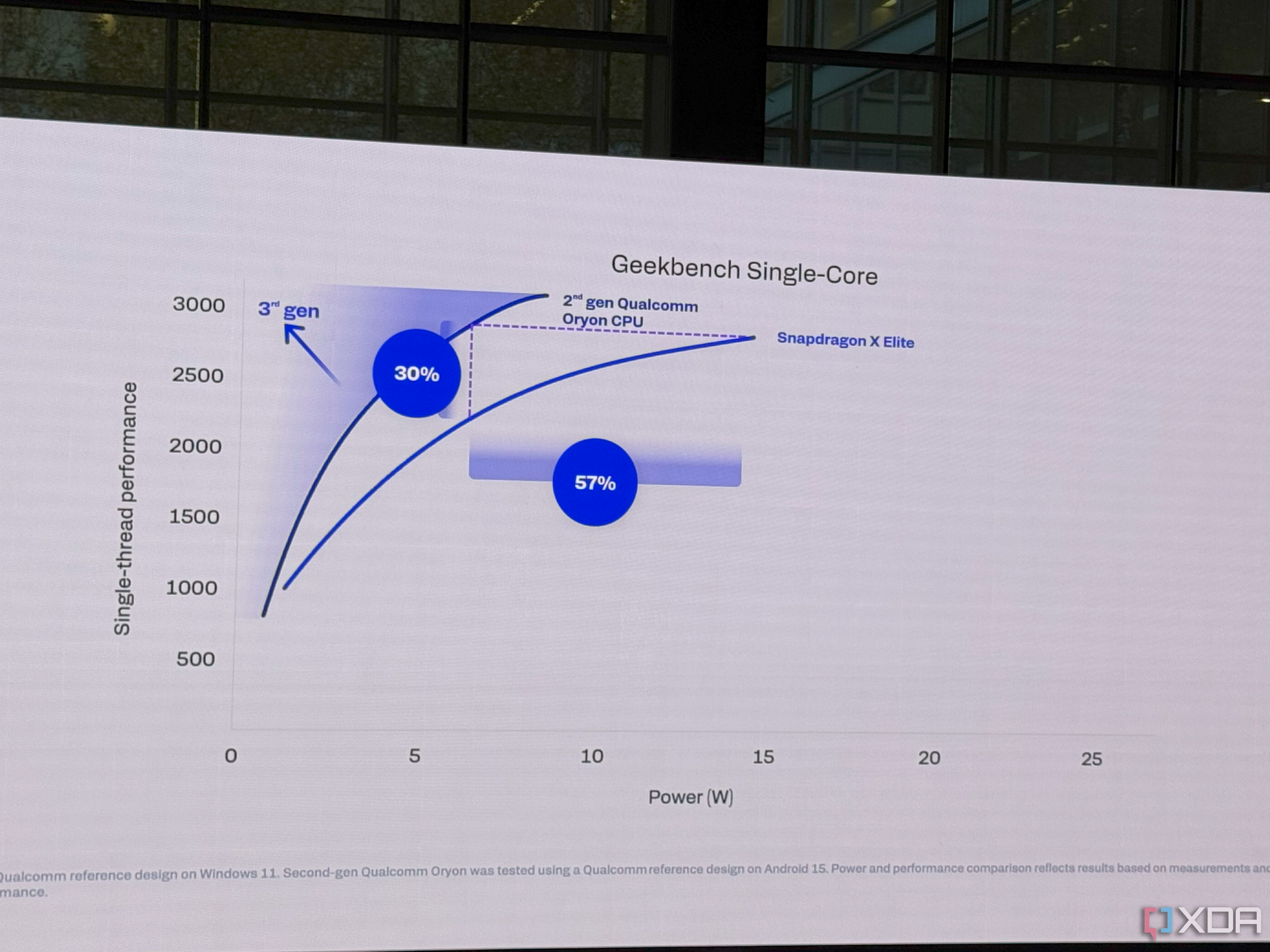

update: dazu passend: Qualcomm hatte bereits vor einiger Zeit schon angedeutet, dass man noch in diesem Jahr die neue "Oryon V3"-CPU präsentieren will. Die legen den Termin praktisch - ... Qualcomm plant Vorstellung der zweiten Snapdragon-X-Generation im September - also wohl auf dem Summit. Der Snapdragon Summit (m.a.W. also die große Hausmesse von Qualcomm) er findet heuer vom 23. bis 25. September 2025 auf Hawaii statt. Auf dieser Hausmesse von Qualcomm, dort werden die meisten Neuvorstellungen präsentiert - m.a. W. . mit all den Neuigkeiten u. Novitäten auf dem Feld von Prozessoren, AI, Automotive u.s.w. Ggf. steht ja dann die 3. Generation der Oryon-CPU auch zur Vorstellung an. Mal sehen - es wird jedenfalls spannend.

noch ein paar

weitere Infos u. mehr: die Qualcomm-page:

https://www.qualcomm.com/company/events mit Daten u. Infos u. Hintergründen

Oryon auf Wikipedia:

Oryon auf Wikipedia:

en.wikipedia.org

Oryon is an 8 to 12-core CPU implementing the ARMv8.7-A architecture featuring a custom microarchitecture designed by Qualcomm.

It is used on the Snapdragon X Plus, Snapdragon X Elite and Snapdragon 8 Elite systems on chips, first released in June 2024.

Qualcomm's Snapdragon X Elite Gen 2 will include third-gen Oryon cores

The Snapdragon X Elite Gen 2 isn't coming until later next year, but Qualcomm is starting to talk about performance.

www.xda-developers.com

Euch allen noch einen schönen Tag.